NeurIPS 2025 Mükafatçıları: Süni İntellektdə Yeni Yaxınlaşmalar və Kəşflər

Keçən həftə

NeurIPS 2025-in Ən Yaxşı Məqalə Mükafatları elan edildi. Bu xəbərlərin ardınca,

süni intellekt sahəsində qabaqcıl araşdırmalar aparan alimlər tərəfindən təqdim olunan mükafatlı və fəxri fərman alan məqalələrin ətraflı icmalı hazırlandı. Bu icmallar müasir maşın öyrənməsinin və dil modellərinin imkanlarını və məhdudiyyətlərini əhatə edir.

“Süni Pətək Ağıl”: Böyük Dil Modellərində Müxtəlifliyin İtiriləsi

Liwei Jiang və həmkarları tərəfindən təqdim olunan araşdırma

Böyük Dil Modellərinin (BBM) çıxış müxtəlifliyini qiymətləndirmək üçün 26 min real açıq-sonlu sorğudan ibarət "INFINITY-CHAT" adlı məlumat dəstini təqdim edir. Tədqiqat nəticəsində "Süni Pətək Ağıl" fenomeni aşkarlanıb ki, burada modellər həm daxili (modeldaxili), həm də müxtəlif model ailələri arasında (modellərarası) eyni cavabları təkrarlamağa meyllidir. Bu tapıntı temperaturu artırmaq və ya model ansambllarından istifadə etməyin müxtəlifliyi təmin etməsi barədə ümumi fərziyyəni alt-üst edir. Müasir RLHF (İnsan Rəyi ilə Gücləndirici Öyrənmə) və təlimat tənzimləməsinin modellərin "yaradıcı" latent məkanını o qədər homogenləşdirdiyi ortaya çıxdı ki, fərqli modellər (məsələn, DeepSeek və GPT-4) açıq-sonlu tapşırıqlarda demək olar ki, eyni şəkildə davranır. Həmçinin, mövcud Mükafat Modellərinin (Reward Models) müxtəlif insan üstünlüklərinə (plüralizmə) zəif kalibr edildiyi və etibarlı, lakin özünəməxsus cavabları düzgün qiymətləndirə bilmədiyi göstərilir.

Gated Attention: LLM Təliminin Sabitliyini Artıran Yeni Mexanizm

Zihan Qiu və Qwen Komandası tərəfindən hazırlanan “Gated Attention” mexanizmi Scaled Dot-Product Attention (SDPA) çıxışından dərhal sonra öyrənilə bilən, girişdən asılı sigmoid qapısı tətbiq edir. Bu metod, diqqət çıxışını bir qapı (σ(XWθ)) ilə modulyasiya etməklə, yekun çıxış proyeksiyasından əvvəl element-aşkar seyrəklik və qeyri-xəttilik yaradır. Bu sadə memarlıq dəyişikliyi böyük miqyaslı təlim üçün dərin sabitlik təkmilləşdirmələri (itki sıçrayışlarını aradan qaldırır) və 15 milyard parametrli MoE (Mütəxəssislərin Qarışığı) və 1.7 milyard parametrli sıx modellərdə daimi olaraq çaşqınlığı yaxşılaşdırır. Ən əsası, bu mexanizm "Diqqət Çuxuru" (Attention Sink) fenomeni və "Kütləvi Aktivasiyalar"ı "çuxur tokenləri" kimi heuristik düzəlişlərə ehtiyac duymadan aradan qaldırır, bununla da uzun kontekstli ekstrapolyasiyanı əhəmiyyətli dərəcədə yaxşılaşdırır.

1000 Qatlı Şəbəkələr: Gücləndirici Öyrənmədə Dərinliyin Faydaları

Kevin Wang və qrupu Təzadlı

Gücləndirici Öyrənmə (CRL) ilə birlikdə müasir arxitektura seçimlərindən (Qalıq bağlantılar, LayerNorm və Swish aktivasiyaları) istifadə edərək gücləndirici öyrənmə (RL) siyasətlərini standart 2-5 qatdan 1000-dən çox qata qədər miqyaslandırmağı bacardı. Bu iş, RL-in dərinlikdən faydalanmadığı barədə mövcud doqmaya meydan oxuyur. SAC kimi standart alqoritmlər daha dərin şəbəkələrlə doyma və ya çökmə yaşasa da, bu tədqiqat Təzadlı RL-in davamlı performans miqyaslandırmasına (20-50 qat artım) imkan verdiyini göstərir. Bu, agentlərə uzun üfüqlü humanoid labirintlərini həll etməyə və açıq mükafat mühəndisliyi olmadan ortaya çıxan lokomotor bacarıqları inkişaf etdirməyə imkan verir.

Niyə Diffuziya Modelləri Yadda Saxlamır: Genişlənmənin Gizli Mexanizmi

Tony Bonnaire, Raphaël Urfin, Giulio Biroli və Marc Mézard tərəfindən aparılan bu iş, NeurIPS 2025-də Ən Yaxşı Məqalə Mükafatına layiq görüldü. Müəlliflər, skor-əsaslı diffuziya modellərinin təlim dinamikasını xarakterizə edən nəzəri və empirik təhlil təqdim edirlər. Modellərin nəticədə həddindən artıq uyğunlaşa biləcəyini qəbul edərək, onlar iki fərqli zaman miqyasını müəyyən edirlər: τgen, modelin etibarlı nümunələr yaratmağı öyrəndiyi, və τmem, modelin müəyyən təlim nümunələrini yadda saxlamağa başladığı zaman. Bu iş, həddindən artıq parametrləşdirilmiş diffuziya modellərinin təlim məlumatlarını mükəmməl şəkildə yadda saxlamaq qabiliyyətinə malik olmasına baxmayaraq niyə ümumiləşdirdiyi paradoksunu həll edir. τmem-in məlumat dəstinin ölçüsü n ilə xətti şəkildə miqyaslandığını, τgen-in isə sabit qaldığını sübut etməklə, məqalə "erkən dayandırmanın" sadəcə bir heuristika deyil,

Zəruri Dinamik Requlyasiya ilə idarə olunan struktur bir zərurət olduğunu ortaya qoyur. Bu, daha böyük məlumat dəstlərinin təlim üçün təhlükəsizlik pəncərəsini niyə genişləndirdiyini və kütləvi modellərin möhkəm şəkildə ümumiləşdirilməsinə imkan verdiyini izah edir.

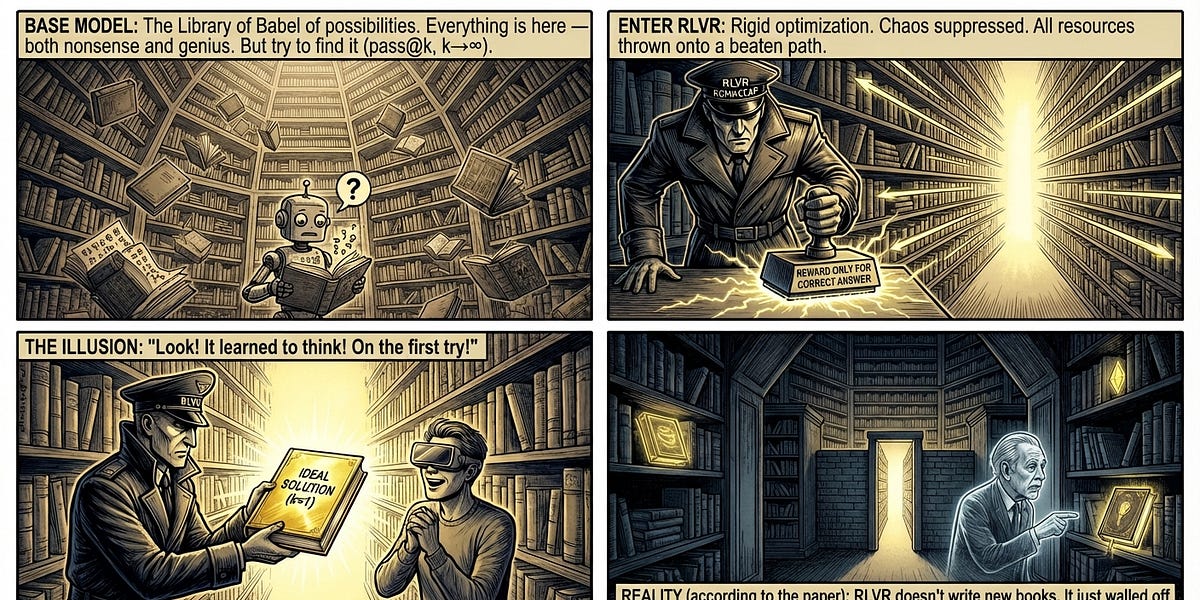

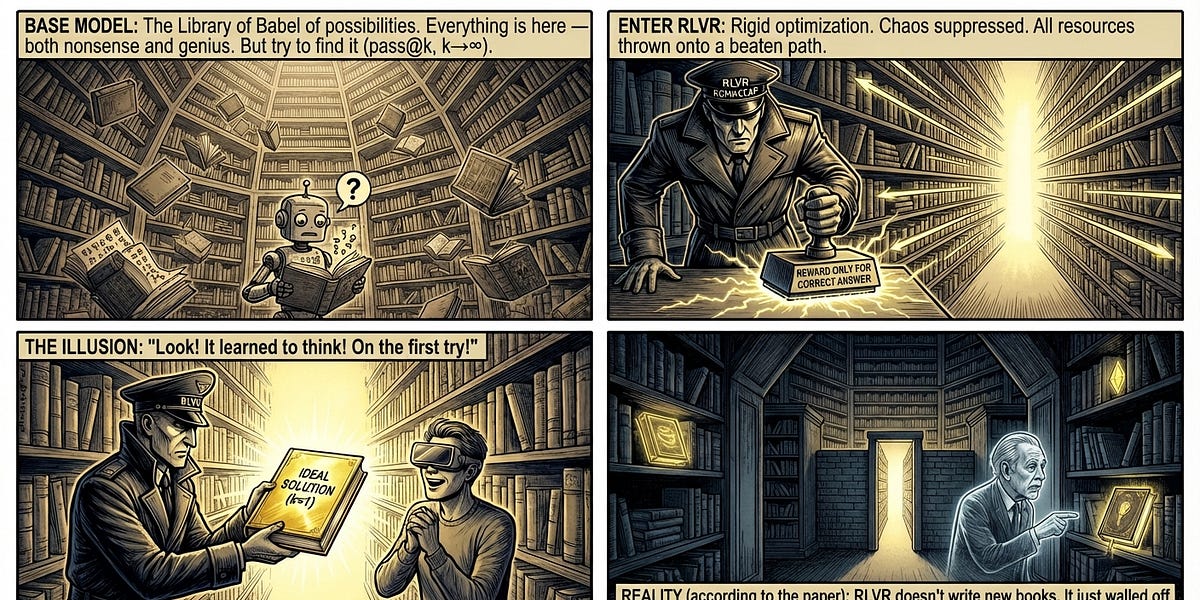

Gücləndirici Öyrənmənin Sərhədləri: Böyük Dil Modellərinin Mühakimə Qabiliyyəti

NeurIPS 2025 Ən Yaxşı Məqalə Fəxri Fərmanına layiq görülən bu işdə Yang Yue və komandası tərəfindən Böyük Dil Modellərinin (BBM) Təsdiqlənə bilən Mükafatlarla Gücləndirici Öyrənmə (RLVR) yolu ilə təlim edilmiş mühakimə sərhədləri sistematik şəkildə araşdırılır. Riyaziyyat, kodlaşdırma və vizual mühakimə tapşırıqları üzrə qərəzsiz “pass@k” metrikası istifadə edilərək, baza modelləri RL tənzimlənmiş həmkarları ilə müqayisə edildi ki, RLVR-in yeni mühakimə nümunələri yaradıb-yaratmadığı və ya sadəcə mövcud olanları gücləndirib-gücləndirmədiyi müəyyən edilsin. Tapıntılar, RLVR-in AlphaGo kimi "insandan üstün" strategiyalar kəşf etməyə imkan verdiyi barədə geniş yayılmış fikrə meydan oxuyur. Tədqiqat göstərir ki, RLVR nümunə götürmə səmərəliliyini əhəmiyyətli dərəcədə artırsa da (düzgün cavablar daha tez-tez görünür), modelin fundamental mühakimə qabiliyyəti sərhədini genişləndirmir. Əslində, böyük k üçün, baza modelləri tez-tez RL tənzimlənmiş versiyalarından daha çox unikal problemi həll edir ki, bu da cari RL metodlarının əvvəlcədən təlim edilmiş modelin prioritetləri ilə məhdudlaşdığını göstərir.

Transduktiv Onlayn Öyrənmədə Optimal Səhv Sərhədləri

Zachary Chase və həmkarları tərəfindən hazırlanan bu məqalə,

öyrənmə nəzəriyyəsində 30 illik açıq bir problemi həll edərək, Transduktiv Onlayn Öyrənmə üçün sıx səhv sərhədlərini təyin edir. NeurIPS 2025-də Ən Yaxşı Məqalə Fəxri Fərmanına layiq görülən bu işdə, Littlestone ölçüsü d olan bir fərziyyə sinfi üçün optimal səhv sərhədinin Θ(sqrt(d)) olduğu sübut edildi. Bu nəticə, "irəliyə baxmağın" nə qədər faydalı olduğunu dəqiq şəkildə ölçür. Bu, gələcək test nöqtələrinin etiketlənməmiş ardıcıllığına girişin standart onlayn mühitlə (sərhədin d olduğu yerlərdə) müqayisədə səhvlərdə kvadratik azalmağa imkan verdiyini sübut edir. Bu, əvvəlki ən yaxşı aşağı sərhəd Ω(logd) və yuxarı sərhəd O(d) arasındakı böyük eksponensial boşluğu aradan qaldırır.

Superpozisiya və Miqyaslanma Qanunları: LLM Təliminin Geometrik Anlayışı

Yizhou Liu, Ziming Liu və Jeff Gore tərəfindən aparılan bu araşdırma,

neyron şəbəkələrinin miqyaslanma qanunları üçün mexaniki bir izahat təklif edir. Bu, "reprezentasiya superpozisiyası" ilə əlaqələndirilir. Seyrək autoenkoder çərçivəsini uyğunlaşdıraraq və açıq mənbəli

Böyük Dil Modelləri (OPT, Pythia, Qwen) üzərində yoxlayaraq, modellərin "güclü superpozisiya" rejimində işləyərkən (ölçülərindən əhəmiyyətli dərəcədə daha çox xüsusiyyəti təmsil edərkən) itkinin modelin genişliyi ilə tərs mütənasib şəkildə miqyaslandığını (L∝1/m) nümayiş etdirirlər. Bu miqyaslanma məlumat quyruğunun statistik xüsusiyyətlərindən daha çox xüsusiyyət vektorları arasındakı həndəsi müdaxilə ilə idarə olunur. NeurIPS 2025 Ən Yaxşı Məqalə Fəxri Fərmanına layiq görülən bu iş, məlumat paylanmasına davamlı miqyaslanma qanunlarının ilk prinsiplərini ortaya qoyur. Manifold təxmininə əsaslanan əvvəlki nəzəriyyələrdən fərqli olaraq, bu tədqiqat BBM-lərin "güc qanunu" davranışının seyrək anlayışları sıx məkanlara sıxışdırmanın həndəsi qaçılmazlığı olduğunu göstərir. Bu, bu miqyaslanma maneələrini aşmaq üçün xüsusiyyət müdaxiləsini idarə etmək üçün memarlıq müdaxilələrinin tələb olunduğunu, çünki sadəcə daha çox məlumat əlavə etməyin həndəsi dar boğazı yan keçə bilməyəcəyini göstərir.

24 saat

NeurIPS 2025 Mükafatçıları: Süni İntellektdə Yeni Yaxınlaşmalar və Kəşflər

Keçən həftə NeurIPS 2025-in Ən Yaxşı Məqalə Mükafatları elan edildi. Bu xəbərlərin ardınca,

süni intellekt sahəsində qabaqcıl araşdırmalar aparan alimlər tərəfindən təqdim olunan mükafatlı və fəxri fərman alan məqalələrin ətraflı icmalı hazırlandı. Bu icmallar müasir maşın öyrənməsinin və dil modellərinin imkanlarını və məhdudiyyətlərini əhatə edir.

“Süni Pətək Ağıl”: Böyük Dil Modellərində Müxtəlifliyin İtiriləsi

Liwei Jiang və həmkarları tərəfindən təqdim olunan araşdırma

Böyük Dil Modellərinin (BBM) çıxış müxtəlifliyini qiymətləndirmək üçün 26 min real açıq-sonlu sorğudan ibarət "INFINITY-CHAT" adlı məlumat dəstini təqdim edir. Tədqiqat nəticəsində "Süni Pətək Ağıl" fenomeni aşkarlanıb ki, burada modellər həm daxili (modeldaxili), həm də müxtəlif model ailələri arasında (modellərarası) eyni cavabları təkrarlamağa meyllidir. Bu tapıntı temperaturu artırmaq və ya model ansambllarından istifadə etməyin müxtəlifliyi təmin etməsi barədə ümumi fərziyyəni alt-üst edir. Müasir RLHF (İnsan Rəyi ilə Gücləndirici Öyrənmə) və təlimat tənzimləməsinin modellərin "yaradıcı" latent məkanını o qədər homogenləşdirdiyi ortaya çıxdı ki, fərqli modellər (məsələn, DeepSeek və GPT-4) açıq-sonlu tapşırıqlarda demək olar ki, eyni şəkildə davranır. Həmçinin, mövcud Mükafat Modellərinin (Reward Models) müxtəlif insan üstünlüklərinə (plüralizmə) zəif kalibr edildiyi və etibarlı, lakin özünəməxsus cavabları düzgün qiymətləndirə bilmədiyi göstərilir.

Gated Attention: LLM Təliminin Sabitliyini Artıran Yeni Mexanizm

Zihan Qiu və Qwen Komandası tərəfindən hazırlanan “Gated Attention” mexanizmi Scaled Dot-Product Attention (SDPA) çıxışından dərhal sonra öyrənilə bilən, girişdən asılı sigmoid qapısı tətbiq edir. Bu metod, diqqət çıxışını bir qapı (σ(XWθ)) ilə modulyasiya etməklə, yekun çıxış proyeksiyasından əvvəl element-aşkar seyrəklik və qeyri-xəttilik yaradır. Bu sadə memarlıq dəyişikliyi böyük miqyaslı təlim üçün dərin sabitlik təkmilləşdirmələri (itki sıçrayışlarını aradan qaldırır) və 15 milyard parametrli MoE (Mütəxəssislərin Qarışığı) və 1.7 milyard parametrli sıx modellərdə daimi olaraq çaşqınlığı yaxşılaşdırır. Ən əsası, bu mexanizm "Diqqət Çuxuru" (Attention Sink) fenomeni və "Kütləvi Aktivasiyalar"ı "çuxur tokenləri" kimi heuristik düzəlişlərə ehtiyac duymadan aradan qaldırır, bununla da uzun kontekstli ekstrapolyasiyanı əhəmiyyətli dərəcədə yaxşılaşdırır.

1000 Qatlı Şəbəkələr: Gücləndirici Öyrənmədə Dərinliyin Faydaları

Kevin Wang və qrupu Təzadlı

Gücləndirici Öyrənmə (CRL) ilə birlikdə müasir arxitektura seçimlərindən (Qalıq bağlantılar, LayerNorm və Swish aktivasiyaları) istifadə edərək gücləndirici öyrənmə (RL) siyasətlərini standart 2-5 qatdan 1000-dən çox qata qədər miqyaslandırmağı bacardı. Bu iş, RL-in dərinlikdən faydalanmadığı barədə mövcud doqmaya meydan oxuyur. SAC kimi standart alqoritmlər daha dərin şəbəkələrlə doyma və ya çökmə yaşasa da, bu tədqiqat Təzadlı RL-in davamlı performans miqyaslandırmasına (20-50 qat artım) imkan verdiyini göstərir. Bu, agentlərə uzun üfüqlü humanoid labirintlərini həll etməyə və açıq mükafat mühəndisliyi olmadan ortaya çıxan lokomotor bacarıqları inkişaf etdirməyə imkan verir.

Niyə Diffuziya Modelləri Yadda Saxlamır: Genişlənmənin Gizli Mexanizmi

Tony Bonnaire, Raphaël Urfin, Giulio Biroli və Marc Mézard tərəfindən aparılan bu iş, NeurIPS 2025-də Ən Yaxşı Məqalə Mükafatına layiq görüldü. Müəlliflər, skor-əsaslı diffuziya modellərinin təlim dinamikasını xarakterizə edən nəzəri və empirik təhlil təqdim edirlər. Modellərin nəticədə həddindən artıq uyğunlaşa biləcəyini qəbul edərək, onlar iki fərqli zaman miqyasını müəyyən edirlər: τgen, modelin etibarlı nümunələr yaratmağı öyrəndiyi, və τmem, modelin müəyyən təlim nümunələrini yadda saxlamağa başladığı zaman. Bu iş, həddindən artıq parametrləşdirilmiş diffuziya modellərinin təlim məlumatlarını mükəmməl şəkildə yadda saxlamaq qabiliyyətinə malik olmasına baxmayaraq niyə ümumiləşdirdiyi paradoksunu həll edir. τmem-in məlumat dəstinin ölçüsü n ilə xətti şəkildə miqyaslandığını, τgen-in isə sabit qaldığını sübut etməklə, məqalə "erkən dayandırmanın" sadəcə bir heuristika deyil,

Zəruri Dinamik Requlyasiya ilə idarə olunan struktur bir zərurət olduğunu ortaya qoyur. Bu, daha böyük məlumat dəstlərinin təlim üçün təhlükəsizlik pəncərəsini niyə genişləndirdiyini və kütləvi modellərin möhkəm şəkildə ümumiləşdirilməsinə imkan verdiyini izah edir.

Gücləndirici Öyrənmənin Sərhədləri: Böyük Dil Modellərinin Mühakimə Qabiliyyəti

NeurIPS 2025 Ən Yaxşı Məqalə Fəxri Fərmanına layiq görülən bu işdə Yang Yue və komandası tərəfindən Böyük Dil Modellərinin (BBM) Təsdiqlənə bilən Mükafatlarla Gücləndirici Öyrənmə (RLVR) yolu ilə təlim edilmiş mühakimə sərhədləri sistematik şəkildə araşdırılır. Riyaziyyat, kodlaşdırma və vizual mühakimə tapşırıqları üzrə qərəzsiz “pass@k” metrikası istifadə edilərək, baza modelləri RL tənzimlənmiş həmkarları ilə müqayisə edildi ki, RLVR-in yeni mühakimə nümunələri yaradıb-yaratmadığı və ya sadəcə mövcud olanları gücləndirib-gücləndirmədiyi müəyyən edilsin. Tapıntılar, RLVR-in AlphaGo kimi "insandan üstün" strategiyalar kəşf etməyə imkan verdiyi barədə geniş yayılmış fikrə meydan oxuyur. Tədqiqat göstərir ki, RLVR nümunə götürmə səmərəliliyini əhəmiyyətli dərəcədə artırsa da (düzgün cavablar daha tez-tez görünür), modelin fundamental mühakimə qabiliyyəti sərhədini genişləndirmir. Əslində, böyük k üçün, baza modelləri tez-tez RL tənzimlənmiş versiyalarından daha çox unikal problemi həll edir ki, bu da cari RL metodlarının əvvəlcədən təlim edilmiş modelin prioritetləri ilə məhdudlaşdığını göstərir.

Transduktiv Onlayn Öyrənmədə Optimal Səhv Sərhədləri

Zachary Chase və həmkarları tərəfindən hazırlanan bu məqalə,

öyrənmə nəzəriyyəsində 30 illik açıq bir problemi həll edərək, Transduktiv Onlayn Öyrənmə üçün sıx səhv sərhədlərini təyin edir. NeurIPS 2025-də Ən Yaxşı Məqalə Fəxri Fərmanına layiq görülən bu işdə, Littlestone ölçüsü d olan bir fərziyyə sinfi üçün optimal səhv sərhədinin Θ(sqrt(d)) olduğu sübut edildi. Bu nəticə, "irəliyə baxmağın" nə qədər faydalı olduğunu dəqiq şəkildə ölçür. Bu, gələcək test nöqtələrinin etiketlənməmiş ardıcıllığına girişin standart onlayn mühitlə (sərhədin d olduğu yerlərdə) müqayisədə səhvlərdə kvadratik azalmağa imkan verdiyini sübut edir. Bu, əvvəlki ən yaxşı aşağı sərhəd Ω(logd) və yuxarı sərhəd O(d) arasındakı böyük eksponensial boşluğu aradan qaldırır.

Superpozisiya və Miqyaslanma Qanunları: LLM Təliminin Geometrik Anlayışı

Yizhou Liu, Ziming Liu və Jeff Gore tərəfindən aparılan bu araşdırma,

neyron şəbəkələrinin miqyaslanma qanunları üçün mexaniki bir izahat təklif edir. Bu, "reprezentasiya superpozisiyası" ilə əlaqələndirilir. Seyrək autoenkoder çərçivəsini uyğunlaşdıraraq və açıq mənbəli

Böyük Dil Modelləri (OPT, Pythia, Qwen) üzərində yoxlayaraq, modellərin "güclü superpozisiya" rejimində işləyərkən (ölçülərindən əhəmiyyətli dərəcədə daha çox xüsusiyyəti təmsil edərkən) itkinin modelin genişliyi ilə tərs mütənasib şəkildə miqyaslandığını (L∝1/m) nümayiş etdirirlər. Bu miqyaslanma məlumat quyruğunun statistik xüsusiyyətlərindən daha çox xüsusiyyət vektorları arasındakı həndəsi müdaxilə ilə idarə olunur. NeurIPS 2025 Ən Yaxşı Məqalə Fəxri Fərmanına layiq görülən bu iş, məlumat paylanmasına davamlı miqyaslanma qanunlarının ilk prinsiplərini ortaya qoyur. Manifold təxmininə əsaslanan əvvəlki nəzəriyyələrdən fərqli olaraq, bu tədqiqat BBM-lərin "güc qanunu" davranışının seyrək anlayışları sıx məkanlara sıxışdırmanın həndəsi qaçılmazlığı olduğunu göstərir. Bu, bu miqyaslanma maneələrini aşmaq üçün xüsusiyyət müdaxiləsini idarə etmək üçün memarlıq müdaxilələrinin tələb olunduğunu, çünki sadəcə daha çox məlumat əlavə etməyin həndəsi dar boğazı yan keçə bilməyəcəyini göstərir.

24 saat

Oxucu Şərhləri

Hələlik heç bir şərh yazılmayıb. İlk şərhi siz yazın!

Şərh Yaz